在机器学习领域,我们经常会遇到模型过拟合(overfitting)的问题。这意味着模型在训练集上表现良好,但在测试集上表现不佳。Bagging是一种用于降低模型过拟合的技术,它可以提高机器学习算法的准确性。

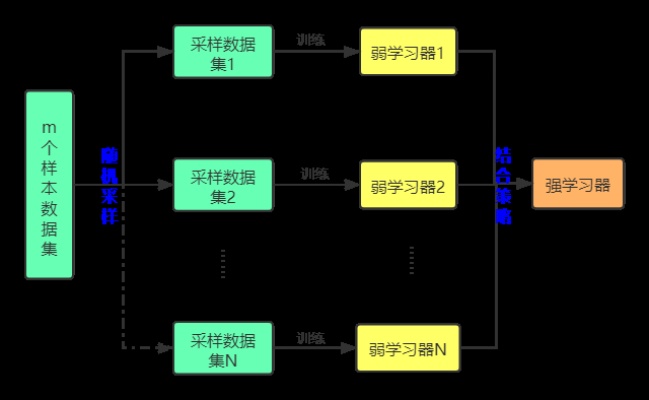

Bagging是Bootstrap Aggregating的缩写,它的基本思想是通过对训练集进行有放回抽样,生成多个子集,然后对每个子集进行训练,最后将多个模型的预测结果进行组合,得到最终的预测结果。Bagging可以用于各种机器学习算法,包括决策树、神经网络、支持向量机等。

Bagging的优点在于它可以减少模型的方差(variance),从而降低过拟合的风险。通过对训练集进行有放回抽样,Bagging可以生成多个子集,每个子集都包含部分训练样本。因此,每个子集训练出来的模型都略有不同,这样可以增加模型的多样性(diversity),从而提高模型的泛化能力(generalization ability)。

Bagging的另一个优点在于它可以并行化处理。由于每个子集都是独立的,因此可以将不同的子集分配给不同的处理器或计算节点,并行地训练多个模型。这样可以大大加快训练速度,提高效率。

Bagging的缺点在于它可能增加模型的偏差(bias)。由于每个子集都是随机生成的,因此可能会包含一些噪声或异常点,这会影响模型的预测能力。此外,Bagging也会增加计算和存储的开销,因为需要训练多个模型并保存它们的预测结果。

总的来说,Bagging是一种有效的机器学习技术,可以提高算法的准确性和泛化能力。在实际应用中,我们可以根据具体情况选择合适的算法和参数,以达到最佳效果。