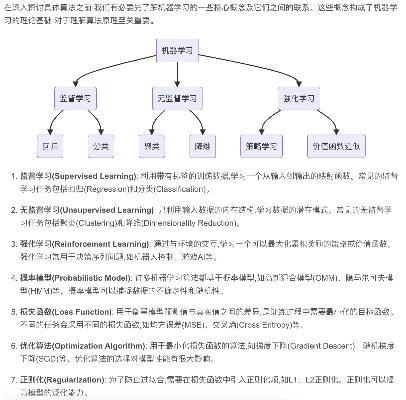

随着人工智能技术的不断发展,机器学习作为其重要分支之一已经得到了广泛应用。机器学习的本质就是通过算法模型来实现对数据的学习和预测,而算法的选择和优化则是机器学习的核心问题之一。本文将深入探讨机器学习中常用的算法原理,为读者提供一份全面的机器学习算法指南。

一、监督学习算法原理

监督学习是机器学习中最常用的一种方法,其基本思想是通过已有的标注数据来训练模型,然后对未知数据进行预测。常见的监督学习算法包括线性回归、逻辑回归、决策树、支持向量机等。这些算法都是通过最小化损失函数来优化模型参数,从而实现对数据的预测。

二、无监督学习算法原理

无监督学习是一种不需要标注数据来训练模型的机器学习方法,其主要目的是发现数据中的内在结构和模式。常见的无监督学习算法包括聚类、降维、生成模型等。这些算法通常是通过最大化似然函数或最小化重构误差来优化模型参数,从而实现对数据的分析和建模。

三、半监督学习算法原理

半监督学习是介于监督学习和无监督学习之间的一种方法,其主要思想是利用少量的标注数据和大量的未标注数据来训练模型。常见的半监督学习算法包括标签传播、生成对抗网络等。这些算法通常是通过最大化半监督损失函数来优化模型参数,从而实现对未标注数据的预测。

四、强化学习算法原理

强化学习是一种通过与环境交互来学习最优策略的机器学习方法,其主要思想是通过试错来逐步提高策略的效果。常见的强化学习算法包括Q-learning、Actor-Critic等。这些算法通常是通过最大化奖励函数来优化策略参数,从而实现对环境的最优控制。

总之,机器学习算法的选择和优化对于机器学习的成功至关重要。本文介绍了常见的监督学习、无监督学习、半监督学习和强化学习算法原理,希望能够为读者提供一份全面的机器学习算法指南,帮助读者更好地理解和应用机器学习算法。