机器学习决策树是一种常见的机器学习算法,它可以用于分类和回归问题。本文将介绍决策树在机器学习中的应用,并解答一些与决策树相关的常见问题。

1. 什么是决策树?

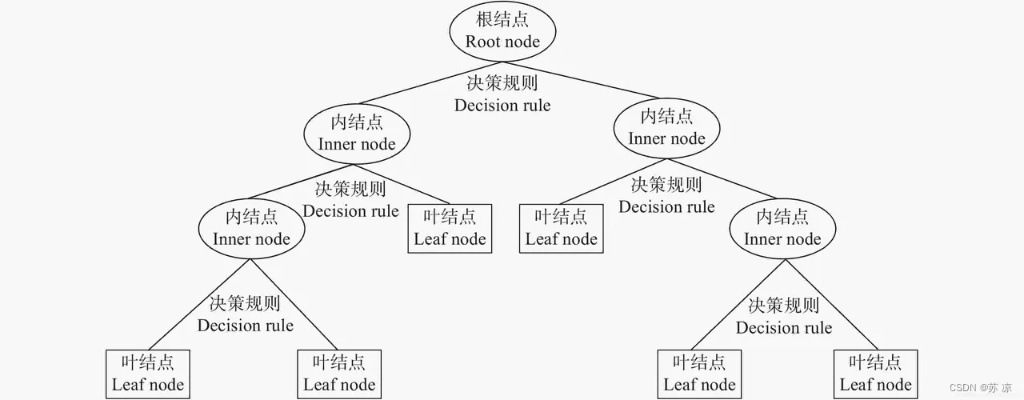

决策树是一种基于树形结构的机器学习算法,它可以用于分类和回归问题。决策树的每个节点表示一个特征,每个分支表示一个特征的取值,每个叶子节点表示一个分类或回归结果。决策树的构建过程是通过对训练集进行递归划分,使得每个子集中的样本尽可能属于同一类别或具有相似的回归值。

2. 决策树的优点是什么?

决策树具有以下优点:

(1)易于理解和解释:决策树的结构清晰,可以很容易地解释。

(2)适用于各种类型的数据:决策树可以处理离散型和连续型的数据。

(3)可以处理高维数据:决策树可以处理高维数据,而且不需要进行特征选择。

(4)计算复杂度低:决策树的训练和预测的计算复杂度都比较低。

(5)具有良好的鲁棒性:决策树对噪声和异常值具有一定的鲁棒性。

3. 决策树的缺点是什么?

决策树具有以下缺点:

(1)容易过拟合:决策树容易过拟合,特别是在处理复杂的问题时。

(2)对于连续型变量需要离散化:决策树对于连续型变量需要进行离散化处理,这样容易丢失一些信息。

(3)不稳定性:决策树的结构容易受到数据的微小变化而改变。

(4)存在欠拟合问题:决策树容易出现欠拟合问题,特别是在处理噪声较多的数据时。

4. 决策树的构建过程是什么?

决策树的构建过程可以分为以下几个步骤:

(1)选择最优特征:从所有特征中选择一个最优特征,使得划分后的数据集尽可能地纯。

(2)划分数据集:根据选择的最优特征,将数据集划分为若干个子集。

(3)递归构建决策树:对于每个子集,重复执行步骤1和步骤2,直到满足停止条件。

(4)剪枝处理:对于已经构建好的决策树,进行剪枝处理,以避免过拟合。

5. 决策树的应用场景有哪些?

决策树可以应用于以下场景:

(1)分类问题:决策树可以用于分类问题,如垃圾邮件分类、疾病诊断等。

(2)回归问题:决策树可以用于回归问题,如房价预测、股票价格预测等。

(3)特征选择:决策树可以用于特征选择,找出对分类或回归有重要贡献的特征。

(4)数据探索:决策树可以用于数据探索,帮助我们了解数据的分布和特征之间的关系。

总之,决策树是一种常见的机器学习算法,具有易于理解和解释、适用于各种类型的数据、计算复杂度低等优点,但也存在过拟合、不稳定性等缺点。在实际应用中,我们需要根据具体问题选择合适的算法和参数,以达到最好的效果。