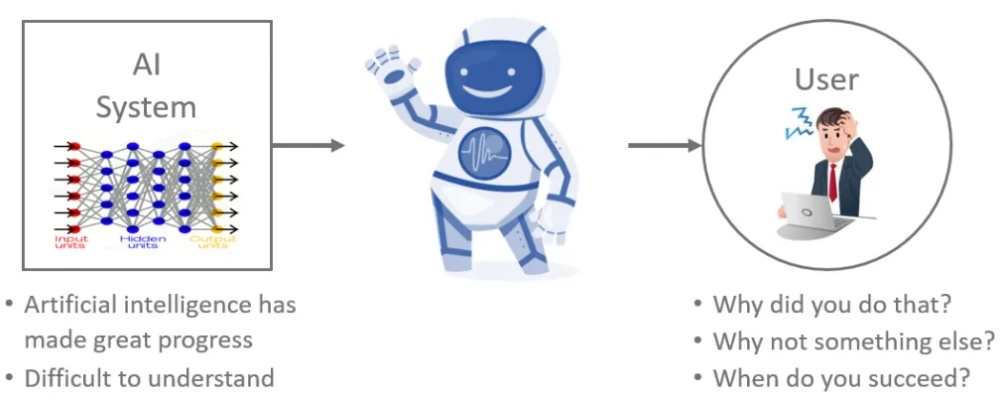

人工智能(AI)技术在各个领域都得到了广泛应用,但是,随着AI技术的不断发展,人们越来越关注AI算法的透明度问题。本文将探讨AI算法的不透明性问题,并从多个角度进行详细描述。

AI算法的不透明性问题

AI算法的不透明性是指人们难以理解AI技术的决策过程和结果。这种不透明性使得人们难以信任AI技术,从而限制了AI技术的应用范围和效果。

AI算法的不透明性问题主要表现在以下几个方面。

1.黑盒算法

黑盒算法是指不可解释或难以解释的算法。这种算法的输入和输出都是可见的,但是中间的决策过程难以理解。例如,深度神经网络就是一种典型的黑盒算法。

2.数据偏差

AI算法的训练数据可能存在偏差,这会影响算法的决策结果。例如,如果一个AI算法只接受男性的训练数据,那么它可能会在处理女性数据时出现错误的决策。

3.算法误判

AI算法可能会出现误判的情况,即算法将正确的数据判断为错误的结果。这种误判可能会导致严重的后果,例如医疗诊断错误、自动驾驶车辆事故等。

4.算法偏见

AI算法可能会受到人类的偏见影响,例如种族、性别、年龄等。这种偏见可能会导致算法对某些人群做出错误的决策。

AI算法的透明度解决方案

针对AI算法的不透明性问题,人们提出了以下解决方案。

1.可解释性算法

可解释性算法是指可以解释或容易解释的算法。这种算法的决策过程可以很好地被理解,从而提高了人们对AI技术的信任程度。

2.数据多样性

为了避免数据偏差问题,人们需要使用多样性的数据来训练AI算法。这样可以提高算法的鲁棒性,从而降低算法的误判率。

3.算法审查

为了发现和纠正算法中的偏见问题,人们需要对算法进行审查。这可以通过数据监督、算法测试、算法审查等方式实现。

4.透明性标准

为了提高AI算法的透明度,人们需要制定透明性标准。这些标准可以帮助人们更好地理解AI算法的决策过程和结果,从而提高人们对AI技术的信任程度。

AI算法的不透明性问题是AI技术面临的一个重要问题。为了解决这个问题,人们需要采取多种措施,包括使用可解释性算法、多样性数据、算法审查和透明性标准等。只有通过这些措施,才能提高人们对AI技术的信任程度,从而推动AI技术的广泛应用和发展。