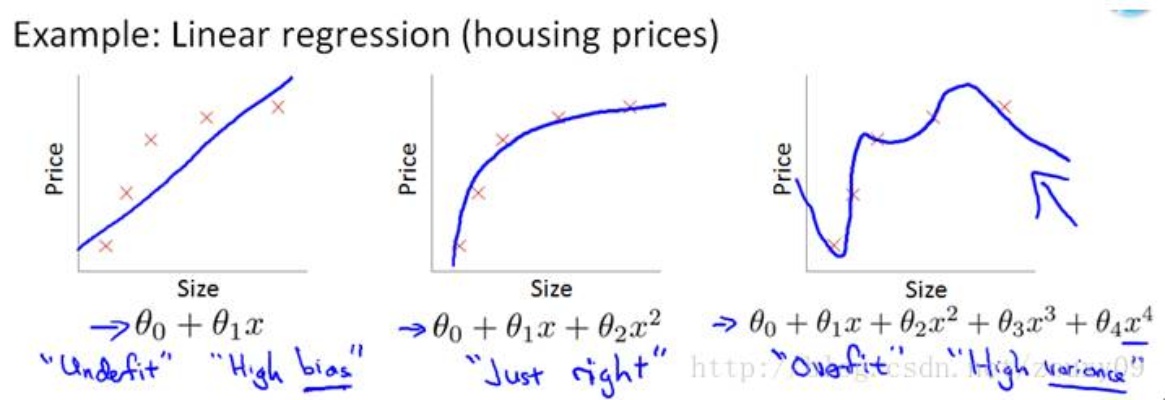

Q:什么是过拟合?

A:过拟合是指机器学习模型在训练数据上表现很好,但在新数据上表现很差的情况。过拟合通常是由于模型过于复杂或训练数据太少导致的。

Q:为什么过拟合会出现?

A:过拟合出现的原因主要是因为模型过于复杂,以至于在训练数据上出现了过多的细节,而这些细节在新数据上并不适用。此外,如果训练数据太少,模型就会过于依赖这些数据,而无法泛化到新数据上。

Q:如何避免过拟合?

A:以下是几种避免过拟合的方法:

1. 增加训练数据:通过增加训练数据,可以让模型更加全面地学习数据的特征,从而减少过拟合的风险。

2. 减少模型复杂度:通过减少模型的复杂度,可以减少过多的细节,从而使模型更加泛化。

3. 使用正则化技术:正则化技术可以通过对模型的参数进行约束来减少过拟合的风险。例如,L1和L2正则化可以通过对模型的参数进行惩罚来避免过拟合。

4. 使用dropout技术:dropout技术可以通过随机地丢弃一些神经元来减少模型的复杂度,从而减少过拟合的风险。

5. 早停法:早停法可以通过在验证集上监测模型的性能来决定何时停止训练,从而避免过拟合。当模型在验证集上的性能开始下降时,就可以停止训练。

Q:有没有实际的例子来说明过拟合的问题?

A:一个例子是,在图像识别中,如果训练数据只包含白色猫的图片,那么模型就会过于依赖白色猫的特征,而无法泛化到其他颜色的猫。因此,如果模型在测试集上看到一只黑色猫,就会无法正确地识别。这就是过拟合的表现。