Q1:什么是人工智能算法模型压缩?

A1:人工智能算法模型压缩是对深度神经网络模型进行优化的方法。该方法通过减少模型中的冗余参数和结构,从而提高模型的效率和准确性。其目的是在不降低模型性能的前提下,减少模型的大小和复杂度,以便在嵌入式设备等资源受限的环境中进行部署。

Q2:为什么需要人工智能算法模型压缩?

A2:深度神经网络模型通常具有大量的参数和复杂的结构,这使得它们在部署和运行时需要大量的计算和存储资源。在一些场景下,如移动端、物联网设备等资源受限的环境中,这些模型的大小和复杂度可能会成为限制它们应用的主要因素。因此,为了在这些场景下能够更好地应用深度神经网络模型,需要对其进行压缩和优化。

Q3:人工智能算法模型压缩有哪些方法?

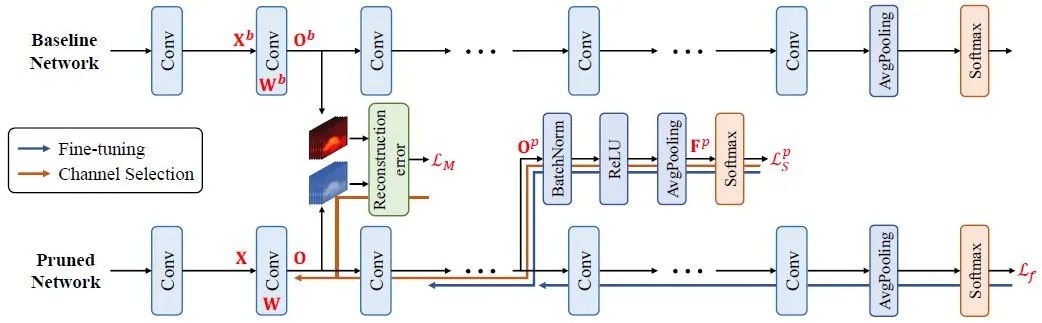

A3:常见的人工智能算法模型压缩方法包括:剪枝、量化、低秩分解等。其中,剪枝是指通过去除模型中不必要的参数和连接来减小模型的大小和复杂度;量化是指将模型中的参数量化为较少的比特数,以减少存储空间和计算量;低秩分解是指将模型中的权重矩阵分解为多个低秩的矩阵,以减少计算量和存储空间等。

Q4:人工智能算法模型压缩的优势是什么?

A4:人工智能算法模型压缩的优势主要体现在以下几个方面:一是可以减少模型的大小和复杂度,提高模型的效率和准确性;二是可以使得深度神经网络模型在资源受限的环境中得以应用,如移动端、物联网设备等;三是可以减少模型的存储空间和计算量,降低模型的能耗和成本等。